Истина станет иллюзией? Как во времена дипфейков научиться распознавать подлинное и мнимое

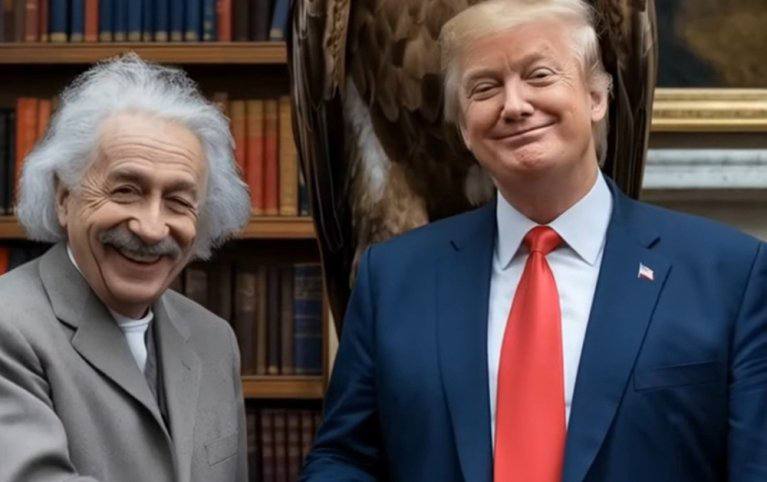

Реакция министра иностранных дел РФ Сергея Лаврова на показанный ему дипфейк с его лицом и голосом была иронической: «Вроде я». Эта фраза, сказанная с легкой усмешкой, отражает не только его личное отношение к подобным технологиям, но и намекает на ту тонкую грань, которая все чаще стирается между реальностью и искусно созданной подделкой. Сегодня дипфейки – это не просто забавные эксперименты энтузиастов, а мощный инструмент, способный манипулировать общественным мнением, дискредитировать личности и даже влиять на геополитические процессы.

Но поддельные фото, видео- и аудиозаписи, созданные с помощью искусственного интеллекта, сегодня стали нешуточным бедствием. Их относят к одному из главных видов информационных угроз, а противостояние им становится актуальнейшей задачей. По своей природе дипфейки используют алгоритмы глубокого обучения, анализируя огромное количество реальных изображений и звуковых записей конкретного человека. Затем эти данные используются для генерации нового контента, где лицо или голос человека накладываются на другое тело или используются для произнесения совершенно иных слов. Это может быть что угодно: от создания фейковых новостей с участием известных политиков, произносящих ложные заявления, до порнографических материалов с использованием лиц знаменитостей без их согласия, что является грубым нарушением приватности и может иметь разрушительные последствия для репутации.

С развитием технологий распознать дипфейк становится все сложнее. Невооруженным глазом отличить подлинное видео от искусно созданной имитации порой невозможно. Несовершенства, которые были заметны на ранних стадиях развития технологии, такие как неестественные движения глаз, артефакты на коже или рассинхронизация звука и изображения, постепенно устраняются. Это создает благодатную почву для распространения дезинформации, которая может иметь далекоидущие последствия. Представьте себе ситуацию, когда в разгар политической кампании появляется видео, где один из кандидатов произносит оскорбительные или дискредитирующие заявления. Даже если позже выяснится, что это дипфейк, ущерб его репутации и шансам на победу может быть непоправимым.

О том, не заменят ли дипфейки истину иллюзией, будет ли разрастаться это явление и что этому можно противопоставить, наш разговор с экспертами. Специалисты в области кибербезопасности, криминалистики и медиаграмотности обсуждают методы обнаружения дипфейков, включая анализ метаданных, выявление аномалий в изображении и звуке, а также разработку специализированного программного обеспечения. Важную роль играет и повышение осведомленности населения. Необходимо формировать критическое мышление, учить людей проверять информацию из нескольких источников, не принимать на веру увиденное или услышанное, особенно если оно вызывает сильные эмоции или кажется слишком сенсационным. Развитие инструментов для верификации контента, внедрение цифровых водяных знаков и блокчейн-технологий для подтверждения подлинности медиафайлов – все это шаги в направлении противодействия растущей угрозе. Однако, как отмечают эксперты, гонка вооружений между создателями дипфейков и теми, кто пытается их разоблачить, будет продолжаться, требуя постоянного совершенствования методов защиты.

Подписаться на https://lenta-novosti-rossii.ru/ в 📱| Читать нас в MAX